谷歌SEO抓取配额是指Googlebot在一定时间内访问和抓取网站页面的限制。抓取配额的分配取决于网站的性能、内容质量和结构等因素。优化抓取配额可以提升Googlebot抓取重要内容的效率,从而加快新内容的索引速度。

抓取配额对SEO优化至关重要。如果页面未被及时抓取和索引,它将无法出现在搜索结果中,直接影响网站的有机流量和可见性。尤其是对于时间敏感的内容,快速抓取和索引可以确保内容的相关性和价值。

本文将帮助您了解如何优化抓取配额,提升网站的整体表现。

核心要点

提高服务器速度,确保响应时间少于300毫秒,能让Googlebot更快工作。

简单明了的网站结构和链接,能帮助Googlebot快速找到重要页面。

提供好的、独特的内容,能吸引Googlebot常来,保证新内容被收录。

定期查看抓取配额的使用情况,及时改变计划,保持网站竞争力。

正确设置robots.txt文件,确保重要页面能被抓取,不浪费抓取配额。

谷歌SEO抓取配额的基础知识

抓取配额的定义

抓取配额是指Googlebot在一定时间内可以抓取网站页面的数量。这一配额由两个核心因素决定:爬行速率限制和爬行需求。爬行速率限制是Googlebot在不影响网站性能的情况下能够抓取的速度,而爬行需求则是Googlebot希望抓取的URL数量。

理想情况下,网站应该尽量缩短新页面创建或更新后与Googlebot再次爬取之间的时间。这种爬取效能是一个重要的SEO指标,直接影响页面的索引速度和搜索引擎的可见性。

定义/参数 | 描述 |

|---|---|

爬行配额 (Crawl Quota) | 搜索引擎为记录和索引特定网站内容而投入的资源,表示特定网站可以被搜索的最大页面数量。 |

爬行速率限制 | 由Googlebot使用的并行连接数和请求之间的时间组成,影响爬行的速度和频率。 |

爬行需求 | Googlebot在单次爬行中访问的URL数量,受内容的受欢迎程度和时效性影响。 |

谷歌如何分配抓取配额

谷歌通过分析网站的性能、内容质量和更新频率来分配抓取配额。以下是一些关键影响因素:

网站性能:快速响应的网站会获得更高的爬取速率限制。

内容更新频率:经常更新的内容会吸引Googlebot更频繁地访问。

链接结构:清晰的内部链接结构有助于Googlebot更高效地抓取页面。

死链接数量:过多的404页面会浪费抓取配额,建议将其状态更改为410。

谷歌会监控网站对其爬虫的响应情况,确保不会因过度爬取而影响网站性能。

抓取配额与抓取频率的关系

抓取配额和抓取频率密切相关。抓取频率是Googlebot访问网站的频率,而抓取配额则是其在一定时间内可以抓取的页面数量。两者的关系受到以下因素的影响:

网站响应速度:快速的网站会提高爬取速率限制,从而增加抓取频率。

内容受欢迎程度:受欢迎的页面会被更频繁地抓取。

内容更新需求:当没有额外内容需要索引时,Googlebot会减少爬取活动。

通过优化网站性能和内容质量,你可以有效提升抓取频率和抓取配额的利用率,从而提高谷歌SEO表现。

抓取配额对SEO的影响

抓取配额不足的常见问题

新内容无法及时被索引

当抓取配额不足时,Googlebot可能无法及时发现和索引新内容。这会直接影响新页面的曝光率,尤其是对于新闻、促销活动等时间敏感的内容。

提示: 如果在Google Search Console中看到“已发现 - 当前未索引”的排除项,这可能表明您的网站存在抓取问题。

此外,低价值网址的存在会进一步浪费抓取资源,例如:

分面导航和会话标识符

重复内容和软错误页面

被黑客攻击的页面或垃圾内容

这些问题会降低爬取效率,导致优质内容的抓取和索引延迟。

旧内容更新无法被识别

抓取配额不足还会影响旧内容的更新识别。Googlebot可能无法及时抓取已更新的页面,导致搜索结果中显示的内容过时。这种情况会降低用户体验,并可能影响网站的可信度。

抓取配额与网站流量的关系

抓取配额的限制会对网站流量产生直接影响。以下是一些关键因素:

影响因素 | 描述 |

|---|---|

爬取频率 | 如果网站长时间未更新或存在robots.txt文件,爬取频率可能下降,进而影响流量。 |

网站性能 | 响应速度快的网站会提高爬取速率限制,从而增加流量。 |

爬取需求 | 内容的受欢迎程度和时效性决定爬取需求,过时内容可能导致爬取活动减少。 |

低价值URL | 低价值URL会消耗爬取资源,导致重要内容未能及时被抓取或索引,影响流量增长。 |

通过优化网站性能和清理低价值URL,你可以有效提升抓取配额的利用率,从而增加网站流量。

抓取配额对网站排名的潜在影响

抓取配额还会影响网站在搜索引擎中的排名表现。内容被创建后,越快被Googlebot抓取,越早出现在搜索结果中。更新后的内容也需要及时被抓取,才能尽快影响排名。

爬取频率的下降可能是由于页面长时间未更新或存在robots.txt文件。网站性能也会影响爬取速率:快速响应的网站会提高爬取速率,而慢速响应或服务器错误会降低爬取速率。

此外,受欢迎的URL通常会被Googlebot更频繁地访问,以保持其在索引中的更新状态。因此,优化抓取配额不仅能提升索引效率,还能帮助你在谷歌SEO中获得更好的排名表现。

影响谷歌SEO抓取配额的因素

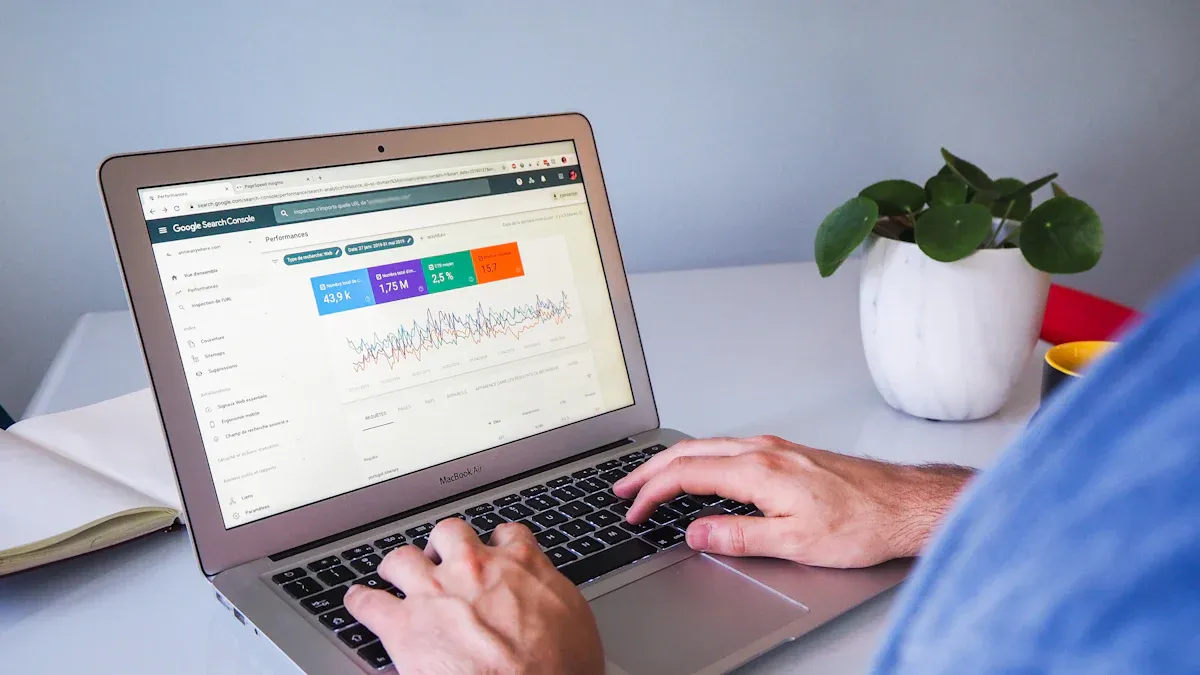

Image Source: unsplash

网站服务器性能

网站服务器性能直接影响Googlebot的爬取速率限制。快速响应的服务器可以让Googlebot更高效地抓取页面,而慢速或不稳定的服务器会降低爬取速率,浪费抓取配额。

提示: 定期监控服务器状态,确保其运行稳定。选择高质量的主机服务,避免因服务器问题导致抓取效率下降。

以下是服务器性能对抓取配额的具体影响:

爬取速率限制:Googlebot会根据服务器的响应速度调整爬取速率。快速响应的网站会获得更高的爬取速率限制。

健康状况:如果服务器频繁出现错误(如500错误),Googlebot可能会减少爬取活动。

优化服务器性能是提升抓取配额利用率的关键一步。

网站结构与内部链接

清晰的网站结构和合理的内部链接布局可以帮助Googlebot更高效地抓取页面。复杂或混乱的结构会导致抓取资源浪费,影响重要内容的索引。

建议: 提供XML站点地图,确保Googlebot能够快速找到所有重要页面。

以下是优化网站结构的几个要点:

内部链接:确保重要页面有足够的内部链接支持,避免孤立页面。

层级结构:减少页面的层级深度,让Googlebot更容易访问深层内容。

死链接清理:定期检查并修复404页面,避免浪费抓取配额。

通过优化网站结构,你可以让Googlebot更高效地抓取和索引内容。

页面加载速度

页面加载速度是影响抓取配额的重要因素。加载速度快的页面可以让Googlebot在相同时间内抓取更多URL,从而提高抓取效率。

提示: 压缩图片和文件,使用CDN加速页面加载。

以下是页面加载速度对抓取配额的具体影响:

爬取速率限制:响应迅速的页面会提高Googlebot的爬取速率限制。

爬取需求:加载速度快的网站更容易吸引Googlebot频繁访问,保持索引的新鲜度。

优化页面加载速度不仅能提升用户体验,还能有效提高谷歌SEO的抓取效率。

网站内容质量

网站内容质量直接影响谷歌SEO抓取配额的分配。高质量的内容更容易吸引Googlebot频繁访问并抓取,从而提高页面的索引效率。以下是提升内容质量的几个关键点:

避免重复内容:重复内容会浪费抓取配额,降低Googlebot的抓取效率。你可以通过规范化URL或使用canonical标签来解决这一问题。

提供独特且有价值的内容:确保每个页面都提供独特的信息,满足用户的搜索需求。Googlebot更倾向于抓取对用户有帮助的内容。

定期更新内容:保持内容的新鲜度。经常更新的页面会吸引Googlebot更频繁地访问,从而提高抓取频率。

优化页面标题和元描述:清晰的标题和描述不仅能吸引用户点击,还能帮助Googlebot更快理解页面内容。

提示: 使用Google Search Console检查哪些页面未被索引,并分析是否存在内容质量问题。

爬虫访问限制(如robots.txt和HTTP状态码)

爬虫访问限制会直接影响抓取配额的使用效率。合理配置robots.txt文件和HTTP状态码,可以帮助Googlebot更高效地抓取重要内容。

robots.txt文件的作用

robots.txt文件用于控制Googlebot的抓取行为。你可以通过以下方式优化其配置:

允许抓取重要页面:确保robots.txt文件未阻止关键页面的抓取。

屏蔽低价值页面:例如,过滤器页面或重复内容页面,可以通过robots.txt文件屏蔽,避免浪费抓取配额。

HTTP状态码的影响

HTTP状态码会影响Googlebot的抓取效率。以下是一些常见问题及其影响:

404错误:404页面会消耗抓取配额,因为Googlebot会尝试抓取这些资源。

无法跟踪的链接:即使页面标记为nofollow,其他页面仍可能爬取这些链接,导致抓取资源浪费。

站点地图中的404资源:如果站点地图包含404 URL,Googlebot会浪费抓取配额在这些无效资源上。

建议: 定期检查站点地图和服务器日志,清理404页面并修复无效链接,确保抓取配额集中用于重要内容。

通过优化爬虫访问规则,你可以有效提升抓取效率,确保Googlebot将资源集中在高价值页面上。

优化谷歌SEO抓取配额的技巧

Image Source: unsplash

提高服务器性能

使用高质量的主机服务

选择高质量的主机服务是优化服务器性能的第一步。快速且稳定的服务器可以显著提高Googlebot的爬取速率限制。研究表明,服务器响应时间低于300毫秒的网站更容易获得更高的爬取速率。你可以通过选择可靠的主机服务商来确保服务器的健康状态,从而提升抓取效率。

定期监控服务器状态

定期监控服务器状态有助于及时发现并解决问题。你可以使用工具检查服务器的响应时间和错误率,确保5xx错误低于1%。如果服务器频繁出现错误,Googlebot可能会减少爬取活动,浪费抓取配额。通过监控和优化服务器性能,你可以为谷歌SEO抓取配额的利用创造更好的条件。

优化网站结构

创建清晰的内部链接结构

清晰的内部链接结构可以帮助Googlebot更高效地抓取页面。简单且易于理解的URL结构能够向搜索引擎展示网站的层次和语义。你可以通过在重要页面之间建立链接,避免孤立页面,来提升抓取效率。此外,内部链接还能引导Googlebot优先抓取高价值内容。

提供XML站点地图

XML站点地图是优化网站结构的重要工具。它可以向Googlebot提供网站的完整页面列表,帮助其快速找到所有重要内容。确保站点地图中没有404页面或重复内容,这样可以避免浪费抓取配额。通过优化站点地图,你可以让Googlebot更高效地抓取和索引网站内容。

提升页面加载速度

压缩图片和文件

压缩图片和文件可以显著提高页面加载速度。加载速度快的页面不仅能提升用户体验,还能让Googlebot在相同时间内抓取更多页面。你可以使用工具压缩图片大小,减少CSS和JavaScript文件的体积,从而优化加载性能。

使用CDN加速

使用内容分发网络(CDN)可以进一步提升页面加载速度。CDN通过将内容分发到全球多个服务器节点,缩短了用户和服务器之间的距离。研究表明,页面加载速度快的网站更容易获得更高的爬取速率限制和爬虫预算。通过使用CDN,你可以有效提高谷歌SEO的抓取效率。

提高内容质量

避免重复内容

重复内容会浪费抓取配额,降低Googlebot的抓取效率。你需要确保每个页面都提供独特的信息。可以通过以下方法避免重复内容:

规范化URL:为相似页面设置规范标签(canonical tag),引导Googlebot抓取正确的页面。

合并重复页面:将内容相似的页面合并为一个页面,集中抓取资源。

检查动态URL:避免因参数不同而生成多个重复页面。

高质量内容能够提高爬虫效率。Googlebot会优先抓取被认为有价值的URL,从而更快地展示新内容或更新内容给用户。

定期更新高质量内容

定期更新内容可以吸引Googlebot更频繁地访问你的网站。以下是一些实用建议:

添加新信息:为现有页面补充最新数据或案例。

优化旧内容:更新页面标题、元描述和关键词,使其更符合用户需求。

删除过时内容:移除已失去价值的页面,避免浪费抓取配额。

通过提供独特且有价值的内容,你可以让谷歌SEO抓取配额得到更高效的利用。

正确配置爬虫访问规则

优化robots.txt文件

robots.txt文件是控制Googlebot抓取行为的重要工具。合理配置可以帮助你集中抓取资源在高价值页面上:

允许抓取重要页面:确保关键页面未被阻止抓取。

屏蔽低价值页面:例如过滤器页面或重复内容页面,可以通过robots.txt屏蔽,避免浪费抓取配额。

定期检查文件:确保robots.txt文件中没有错误配置,避免影响抓取效率。

处理404和500错误页面

HTTP状态码会直接影响Googlebot的抓取效率。以下是一些优化建议:

修复404页面:定期检查并修复404错误,减少抓取资源浪费。

优化500错误:确保服务器稳定运行,避免因500错误导致爬取活动减少。

清理站点地图:移除站点地图中的无效URL,确保Googlebot专注于重要内容。

优化爬虫访问规则时,你还可以利用XML站点地图引导Googlebot抓取关键页面。通过这些方法,你能够有效提升抓取效率,让谷歌SEO表现更出色。

监控和评估抓取配额的使用情况

使用Google Search Console查看抓取统计

Google Search Console 是监控抓取配额使用情况的强大工具。通过它,你可以查看过去 90 天内 Googlebot 的爬取活动,包括哪些页面被抓取以及抓取频率。这些数据有助于你了解抓取配额的使用效率,并发现潜在问题。

以下是 Google Search Console 提供的一些关键爬取统计指标:

爬虫统计指标 | 描述 |

|---|---|

总爬取请求 | 测量在给定时间段内,Google 对你网站 URL 的总爬取次数,包括成功和失败的请求。 |

总下载大小 | 反映 Google 在爬取过程中下载的内容总量,较高的平均值可能表示 Google 频繁爬取你的网站。 |

平均响应时间 | 告诉你搜索引擎请求页面内容所需的时间,数值越低,表示 Google 在你的网站上花费的时间越少。 |

主机状态 | 显示 Google 在过去 90 天内尝试爬取网站时遇到的可用性问题,包括 robots.txt 文件、DNS 解析和服务器连接问题。 |

爬取请求细分 | 按响应、文件类型、目的和 Googlebot 类型对爬取请求进行细分,帮助分析不同类型的请求。 |

通过这些数据,你可以优化服务器性能、清理低价值内容,并确保重要页面被优先抓取。

分析服务器日志文件

服务器日志文件记录了 Googlebot 与网站的交互细节,是分析抓取配额使用情况的重要资源。通过日志文件,你可以识别哪些页面被频繁抓取,哪些页面未被抓取,以及是否存在抓取错误。

以下是分析服务器日志的步骤:

确保服务器响应快速且健康。

清理低价值内容,避免浪费抓取配额。

审查索引控制,确保重要页面被正确抓取。

使用 robots.txt 文件告诉 Googlebot 不该爬取的内容。

筛选相关链接,优化内部链接结构。

审计剩余的爬取问题,及时修复错误。

通过这些步骤,你可以更好地管理抓取配额,提升谷歌SEO表现。

定期检查抓取错误和警告

抓取错误和警告会直接影响抓取配额的使用效率。你需要定期检查 Google Search Console 中的抓取错误报告,识别并解决问题。例如,404 错误页面会浪费抓取资源,而重定向链可能导致加载时间延长。

以下是减少抓取错误的最佳实践:

管理 URL 库存,使用 robots.txt 和规范标签帮助 Google 找到重要页面。

通过规范标签和 301 重定向解决重复内容问题。

清理重定向链,避免多个重定向影响加载速度。

确保服务器响应快速,5xx 错误率低于 1%。

使用内部链接引导爬虫,确保重要页面在三次点击内可达。

通过这些方法,你可以优化抓取效率,确保 Googlebot 将资源集中在高价值页面上。

谷歌SEO抓取配额是提升网站表现的关键。优化服务器性能、网站结构和内容质量能够显著提高爬虫配额的使用效率。

高效的服务器可以快速响应Googlebot的爬取请求,确保服务器响应时间低于300毫秒,同时将5xx错误率控制在1%以下。

清晰的网站结构和高质量内容能帮助Googlebot优先抓取重要页面,让新内容和更新内容更快出现在搜索结果中。

定期监控抓取配额的使用情况,及时调整优化策略,可以让你的网站在竞争中保持优势。

FAQ

1. 什么是抓取配额的“爬行速率限制”?

爬行速率限制是指Googlebot在不影响网站性能的情况下抓取页面的速度。服务器响应越快,Googlebot的爬行速率限制越高。

提示: 定期优化服务器性能,确保响应时间低于300毫秒。

2. 如何检查我的网站是否存在抓取配额问题?

你可以通过Google Search Console查看抓取统计数据,关注“已发现 - 当前未索引”的页面。分析服务器日志文件也能帮助你发现未被抓取的页面。

建议: 定期检查抓取错误并优化低价值内容。

3. robots.txt文件会影响抓取配额吗?

会。robots.txt文件可以控制Googlebot的抓取行为。如果配置不当,可能会阻止重要页面的抓取,浪费抓取配额。

注意: 确保robots.txt文件允许抓取关键页面,并屏蔽低价值页面。

4. 为什么我的新内容没有被及时索引?

抓取配额不足可能导致新内容未被及时抓取。低价值URL、重复内容或服务器性能问题都会浪费抓取资源。

解决方法: 提供高质量内容,清理无效页面,优化服务器性能。

5. 页面加载速度如何影响抓取配额?

加载速度快的页面可以让Googlebot在相同时间内抓取更多页面。慢速页面会降低爬行速率限制,浪费抓取配额。

提示: 压缩图片,使用CDN,减少JavaScript文件大小以提升加载速度。

Ready to Transform Your Content?

Join thousands of content creators using QuickCreator to produce high-quality content faster. Start your 14-day free trial today.

Start Free Trial